L’importance du SEO pour se positionner sur les assistants vocaux

« Ok Google, quelle sera la météo aujourd’hui ? ». Qui pourrait se passer de l’aide des assistants vocaux ?

Cette phrase, que vous avez sans doute entendue, ou même prononcée, plusieurs fois appartenait pourtant il y a quelques années à la science-fiction pure. Pourtant, les assistants de recherche vocale sont de plus en plus communs dans notre quotidien.

Alexa, Google Assistant, Siri : la recherche vocale est une véritable mine d’or. Jumelée avec l’expansion rapide du secteur des téléphones intelligents, elle représente une opportunité incontournable pour les départements marketing qui savent l’intégrer à leur stratégie.

Les assistants vocaux : un marché en pleine expansion

La recherche vocale constitue l’un des domaines technologiques qui croissent le plus rapidement. Pourtant, rien ne laissait présager à l’origine que les assistants vocaux deviendraient partie intégrante de nos habitudes quotidiennes.

C’est d’abord Apple qui a lancé le bal, en proposant son assistante vocale, Siri, sur son tout nouvel iPhone 4S. L’offre était révolutionnaire : une intelligence artificielle pouvant vous aider dans vos tâches et vos questionnements. Et la compétition a tout de suite compris cet aspect.

Rapidement, le géant de la vente en ligne Amazon lançait Alexa, son propre assistant vocal. C’était une autre petite révolution. En effet, plutôt que d’être lié à un téléphone intelligent, Alexa possède son propre appareil, doublé d’un haut-parleur. C’était donc l’une des premières incursions de la recherche vocale dans le domicile de ses utilisateurs.

Google a, à son tour, lancé son Google Assistant en 2016, de même que son Google Home (son équivalent au Alexa) en 2017. Amazon et Google ont d’ailleurs d’ores et déjà surpassé Apple et sont maintenant les deux grands leaders de ce marché en pleine expansion.

En plein envol, le marché des assistants de recherche vocale n’est pas sur le point de faire faillite. Alors que le monde numérique est de plus en plus intégré avec le monde physique, on prévoit qu’il y aura 3 fois plus d’assistants vocaux vendus en 2025 qu’en 2020. En effet, d’ici 5 ans, près de 75% des ménages américains en possèderont au moins un.

La position 0, garante du succès sur la recherche vocale

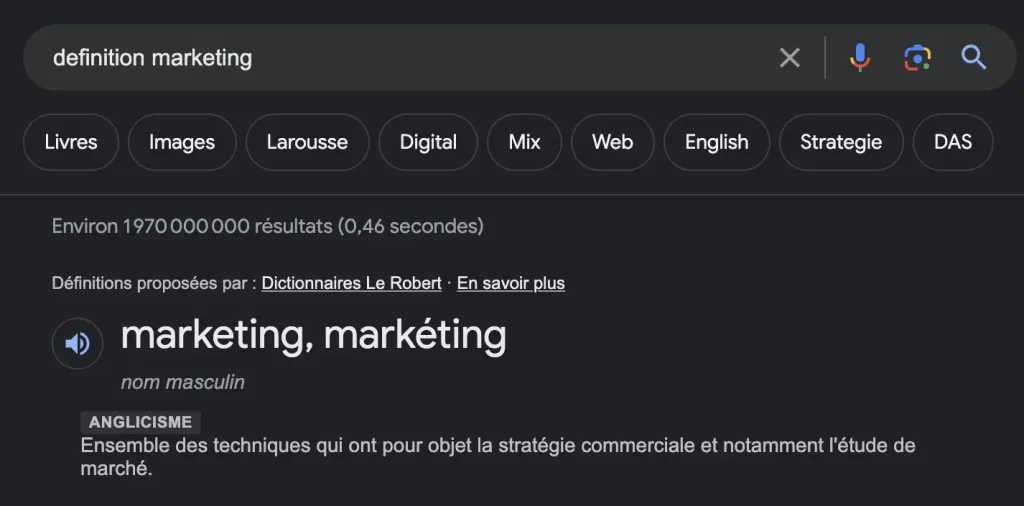

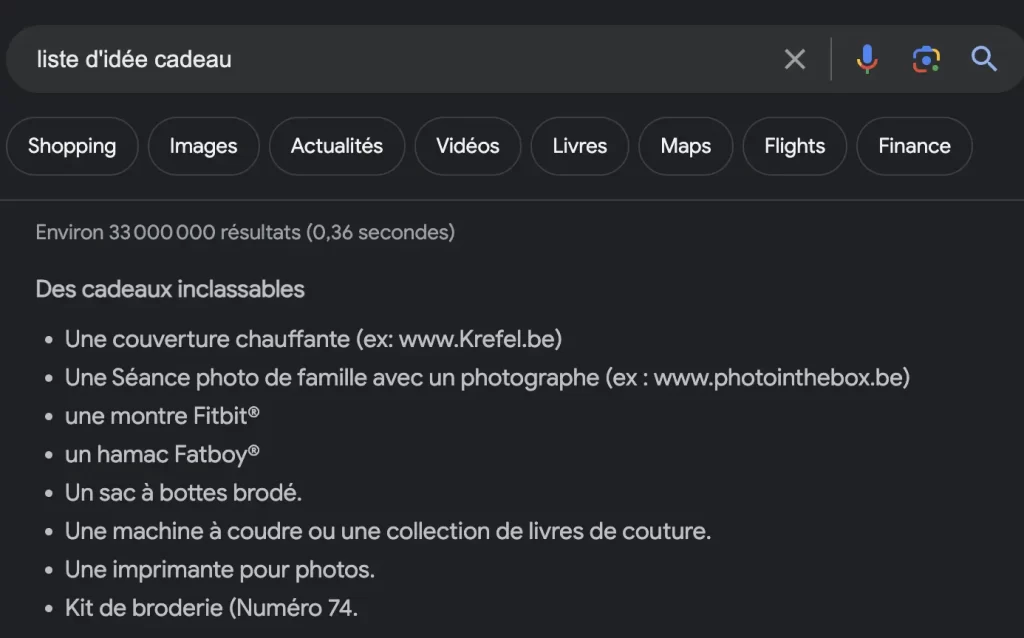

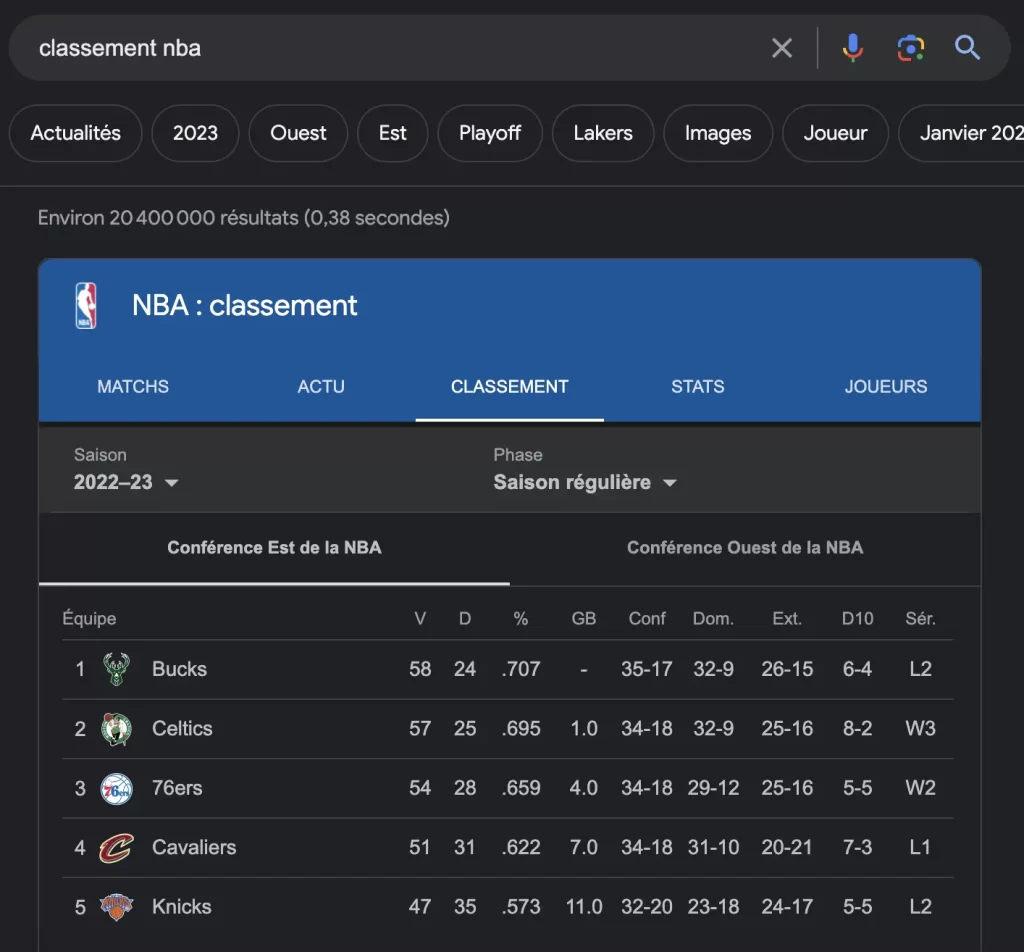

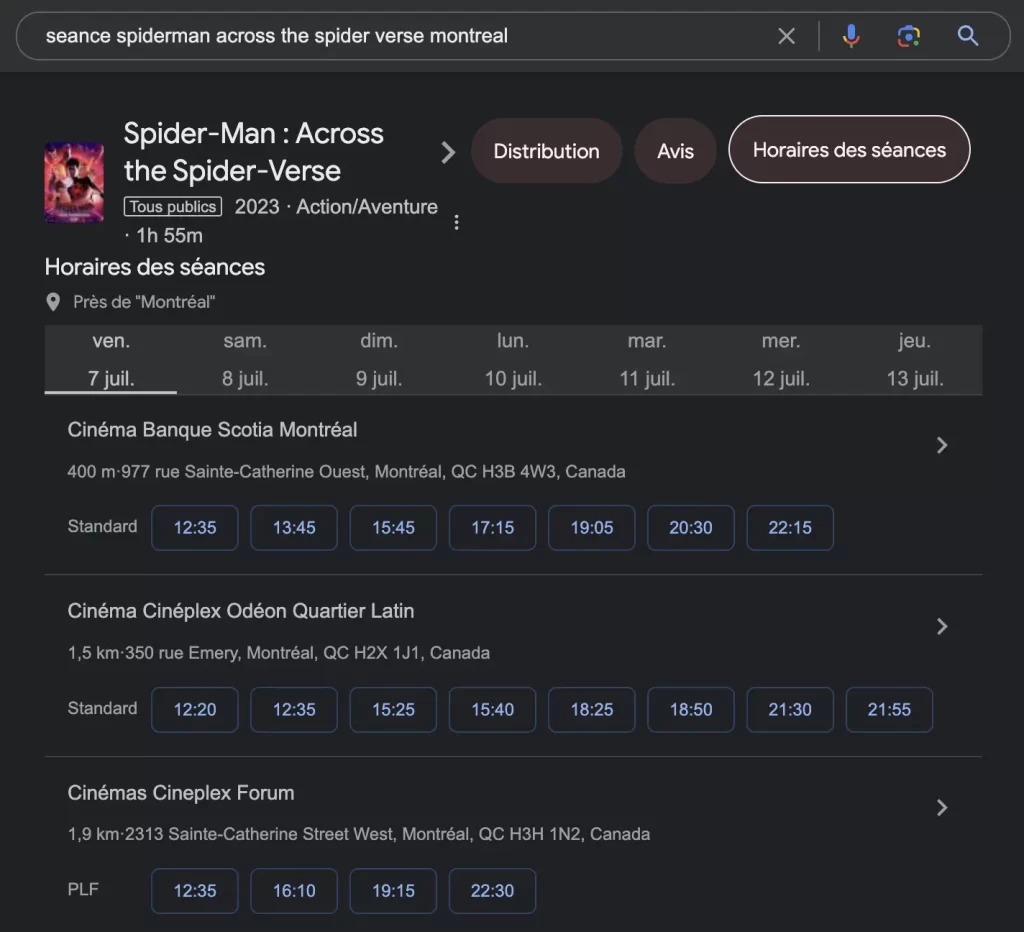

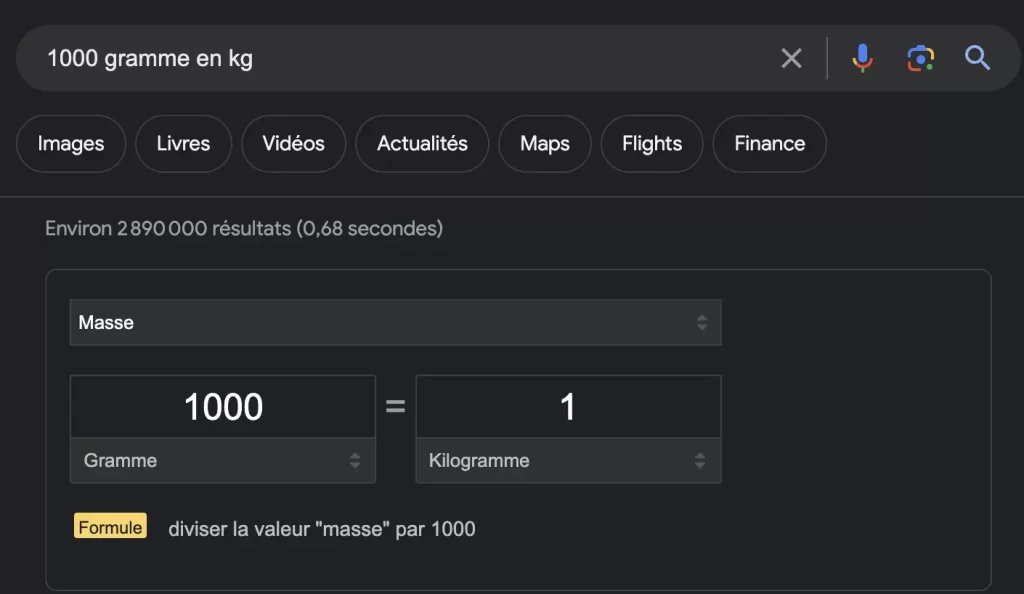

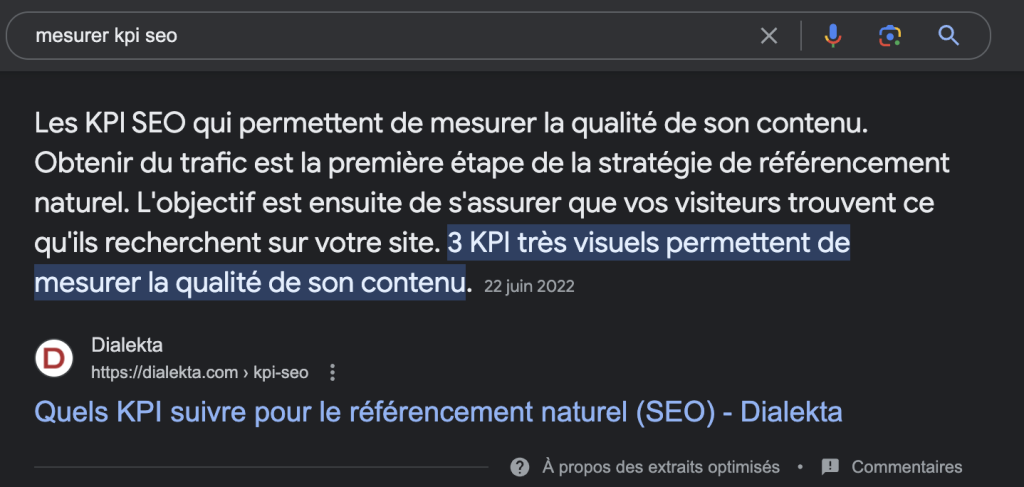

La clé du succès pour être cité sur les assistants vocaux repose avant tout sur une optimisation du référencement organique en vue de décrocher la position 0. Celle-ci est aussi connue sous le nom de featured snippet.

Vous avez sans doute déjà aperçu un résultat en position 0. Il s’agit généralement d’un encadré se classant au sommet des résultats d’une recherche, avant même les résultats payants. Dans le cas des assistants vocaux, la position 0 est celle qui est énoncée à voix haute par l’assistant, en réponse à la recherche de l’utilisateur.

L’intérêt de la position 0 est qu’elle offre une visibilité incomparable en se positionnant en première place sur les moteurs de recherche, au-dessus des résultats organiques et des annonces payantes. Elle est l’objectif qu’une bonne optimisation SEO permet d’atteindre.

La position 0 a donc le double avantage d’être celle qui sera priorisée par l’assistant vocal ainsi que d’être le premier résultat d’une recherche Google. Et évidemment, comme il n’y a qu’une seule position 0, la lutte pour l’occuper fait rage. Il vous faut donc savoir comment positionner son contenu sur les assistants vocaux pour en profiter.

Comment se positionner sur les assistants vocaux ?

Le positionnement sur les assistants vocaux ressemble à celui sur les moteurs de recherche. Pour obtenir des résultats intéressants pour votre marque, il convient avant tout d’optimiser votre référencement organique. Cela peut être accompli en travaillant 3 aspects complémentaires du SEO de votre site.

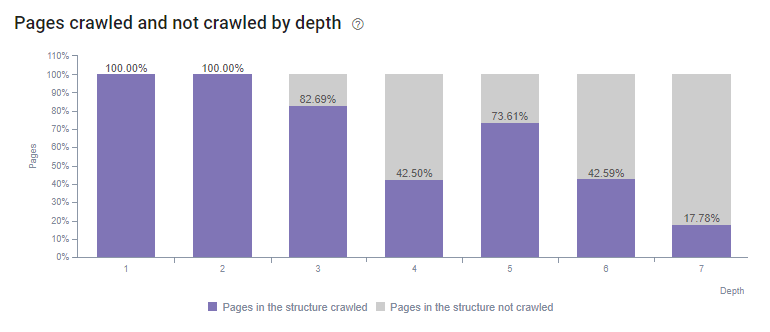

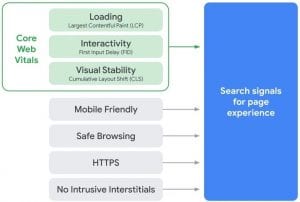

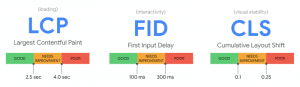

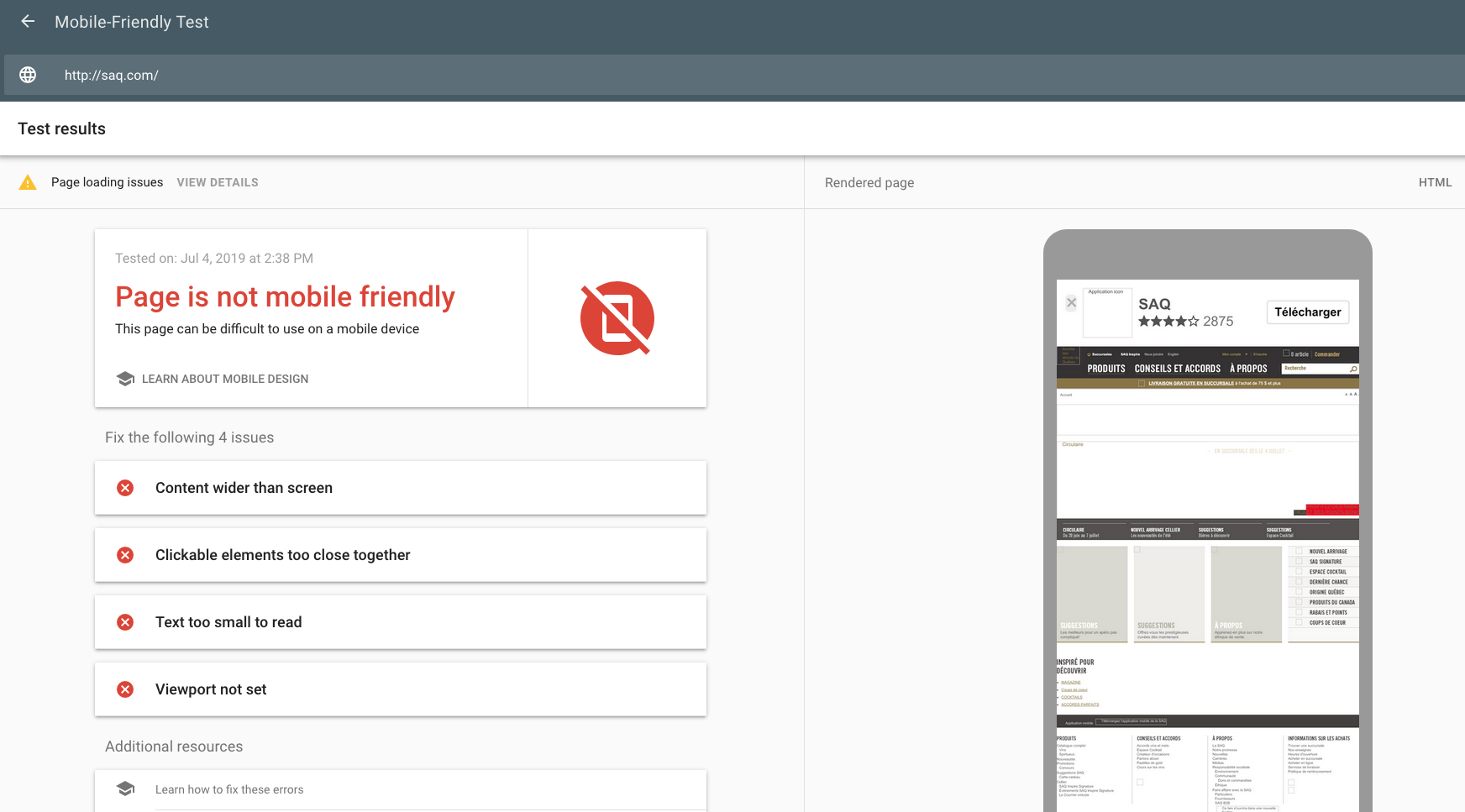

Optimiser le SEO technique

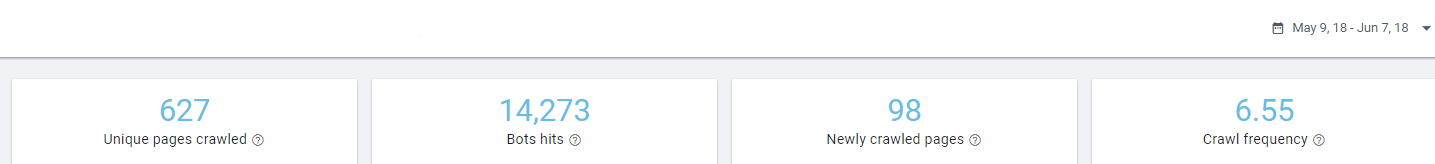

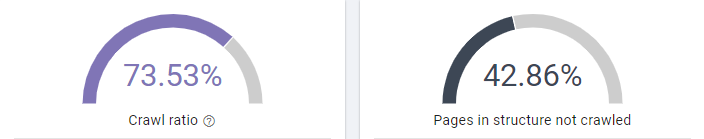

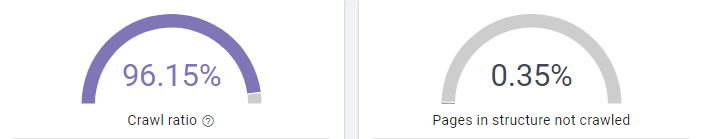

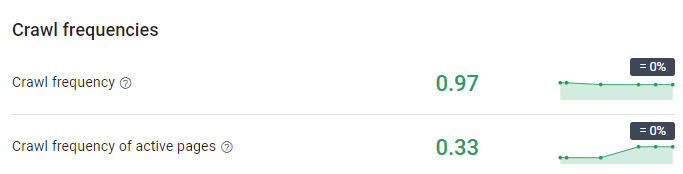

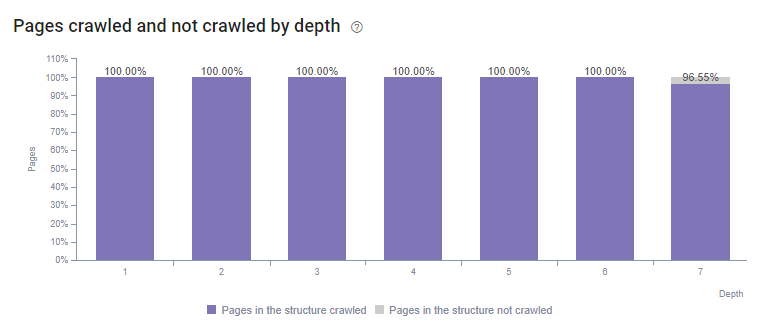

L’optimisation du SEO technique concerne, comme son nom l’indique, le volet technique d’un site Web. Il s’agit du volet le plus important aux yeux des robots d’indexation des moteurs de recherches de Google. Il consiste à optimiser la structure du site web. Ces robots ou « crawlers » s’attardent principalement aux critères suivant:

- La rapidité du site Web

- L’absence d’erreurs sur le site Web

- L’arborescence et la structure des URLs

- L’optimisation des fichiers robots.txt et sitemap.xml

- L’optimisation des balises

Un site dont l’aspect technique est mal optimisé ne se classera donc pas très bien dans les résultats d’une recherche, qu’elle soit vocale ou via les moteurs de recherche.

Optimiser le SEO de contenu

L’optimisation du contenu d’un site Web est ce que l’on associe le plus souvent au SEO. Comme ce sont les robots d’indexation qui font le travail de recherche pour les utilisateurs, il est primordial d’optimiser le contenu d’un site de sorte qu’ils le détectent. Cette optimisation implique quelques principes clés.

- La structure du contenu

Il faut s’assurer que chaque page ne réponde qu’à un seul objectif (ne traîte que d’un seul thème) et que le contenu du site soit correctement structuré pour être facilement interprété par les robots d’indexation. Il faut donc bien hiérarchiser le contenu des pages en fonction de leurs titres (H1), sous-titres (H2) et sous-sous-titres (H3 et plus) selon un ordre logique.

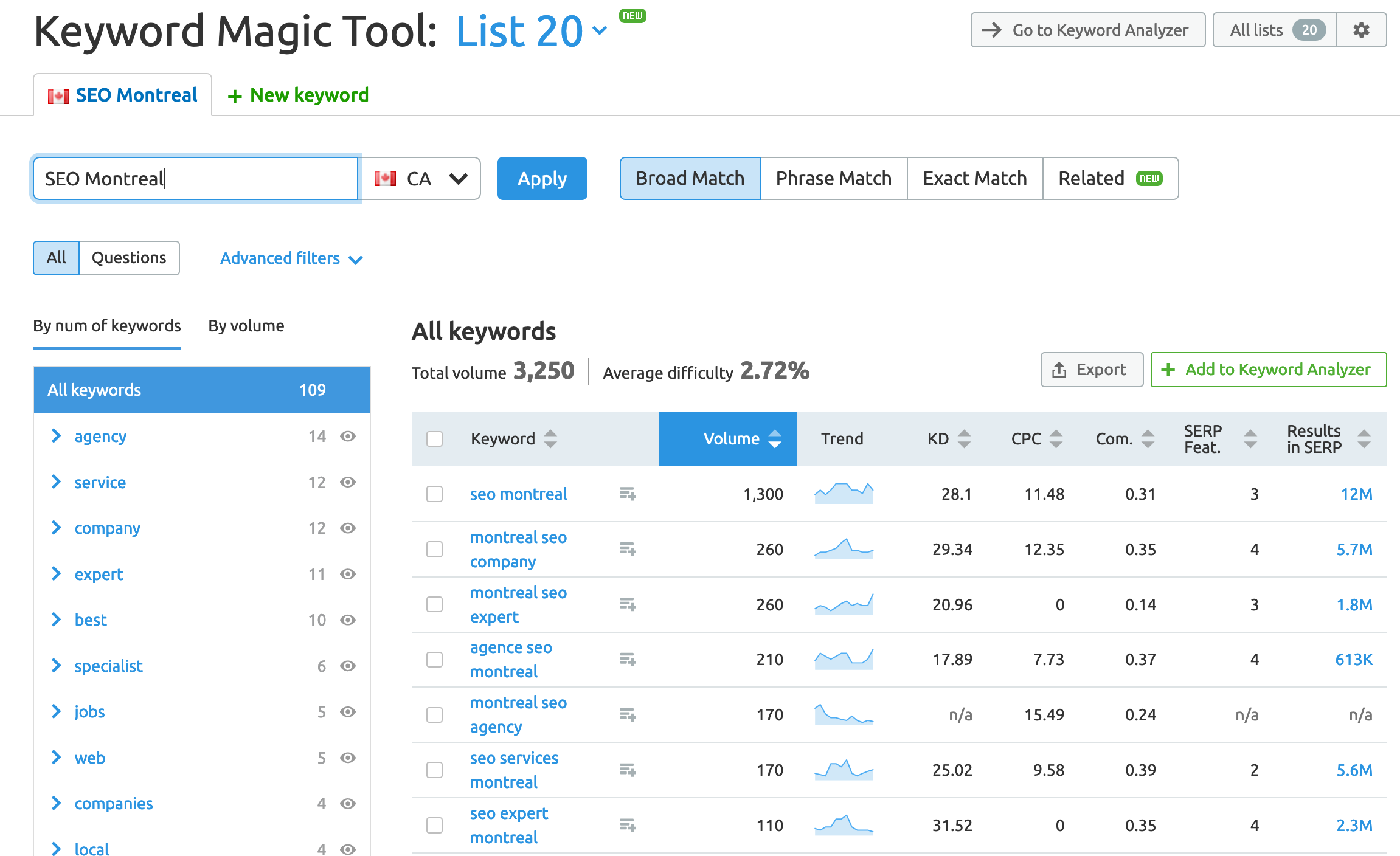

- L’intégration de mots-clés

Les mots-clés sont un des éléments les plus importants de l’indexation. Lorsqu’un utilisateur fait une recherche, le moteur lui affichera les résultats qui correspondent le mieux à sa requête. Pour ce faire, il faut intégrer des mots-clés qui correspondent aux recherches des utilisateurs, mais également à l’objectif de la page.

- La pertinence du contenu

Pour qu’une page soit bien indexée par les moteurs de recherche, autant traditionnels que vocaux, il faut qu’elle réponde à un besoin. Il faut donc s’assurer que le contenu qui a été produit réponde à une question d’un utilisateur, qu’il sera véritablement recherché.

Optimiser le SEO vocal

Alors que les deux points précédents ne sont pas exclusifs à l’optimisation SEO pour la recherche vocale, celle-ci impose une nouvelle contrainte. En effet, les assistants vocaux proposent d’abord les sites Web optimisés pour la recherche vocale.

Cette optimisation concerne premièrement la nature du contenu. Celui-ci doit adopter une forme plus interrogative, étant donné que les recherches vocales sont très souvent faites sous forme de questionnements. De plus, la réponse qu’il donne doit être claire et succincte. Elle doit pouvoir rapidement répondre aux questions « qui », « quoi », « quand », etc.

La section FAQ d’un site Web est l’endroit idéal pour rédiger du contenu de cette nature. Il est facile d’y ajouter des requêtes interrogatives et mettre en place des réponses bien structurées.

Une expertise en référencement pour profiter de la recherche vocale

Comme les assistants vocaux sont en pleine expansion, c’est le meilleur moment pour s’y intéresser en commençant par optimiser son référencement organique.

Si vous avez besoin d’aide dans votre stratégie SEO, contactez notre agence SEO à Montréal. L’équipe de Dialekta vous offre en effet l’expertise nécessaire pour vous aider à tirer votre épingle du jeu.

Par Geoffrey Perrochon

Rigoureux et méthodique, Geoffrey a rapidement développé un intérêt pour la gestion de projets. Mesurer, analyser, améliorer, contrôler et consolider c’est ce qu’il aime faire au quotidien. Pas étonnant qu’Excel soit son outil de prédilection. Après 6 ans d’expérience en marketing côté client, il se spécialise dans le numérique et rejoint Dialekta pour y assurer la gestion des projets média et SEO. Toujours disponible et de bonne humeur, Geoffrey sait établir une relation de confiance essentielle pour avancer sereinement.

Rigoureux et méthodique, Geoffrey a rapidement développé un intérêt pour la gestion de projets. Mesurer, analyser, améliorer, contrôler et consolider c’est ce qu’il aime faire au quotidien. Pas étonnant qu’Excel soit son outil de prédilection. Après 6 ans d’expérience en marketing côté client, il se spécialise dans le numérique et rejoint Dialekta pour y assurer la gestion des projets média et SEO. Toujours disponible et de bonne humeur, Geoffrey sait établir une relation de confiance essentielle pour avancer sereinement.

Laura travaille en marketing numérique depuis plus de 5 ans. En tant que stratège média numérique, elle supporte ses clients dans leur croissance sans jamais perdre de vue leurs objectifs marketing. Passionné par les chiffres, elle est spécialisée dans les comptes à la conversion et le commerce électronique.

Laura travaille en marketing numérique depuis plus de 5 ans. En tant que stratège média numérique, elle supporte ses clients dans leur croissance sans jamais perdre de vue leurs objectifs marketing. Passionné par les chiffres, elle est spécialisée dans les comptes à la conversion et le commerce électronique.

Il est plus facile d’arriver en position zéro si une page se positionne déjà bien dans les SERP. Vous pouvez même identifier, grâce à des outils comme

Il est plus facile d’arriver en position zéro si une page se positionne déjà bien dans les SERP. Vous pouvez même identifier, grâce à des outils comme  Arriver en position 0 c’est bien, mais sur une requête qui a un bon volume de recherche c’est mieux. Il est donc primordial de savoir comment recherchent les internautes. Avecdes outils comme

Arriver en position 0 c’est bien, mais sur une requête qui a un bon volume de recherche c’est mieux. Il est donc primordial de savoir comment recherchent les internautes. Avecdes outils comme